公司

Security&AI持續(xù)深耕,安恒信息研究成果獲國(guó)際學(xué)術(shù)會(huì)議認(rèn)可

近日,安恒信息中央研究院安通鑒博士帶領(lǐng)的AI安全團(tuán)隊(duì)針對(duì)網(wǎng)絡(luò)攻防場(chǎng)景的基于深度學(xué)習(xí)的webshell檢測(cè)的研究成果“Deep Learning Based Webshell Detection Coping with Long Text and Lexical Ambiguity”,被高等級(jí)國(guó)際學(xué)術(shù)會(huì)議ICICS International Conference on Information and Communications Security 2022(隸屬中國(guó)計(jì)算機(jī)學(xué)會(huì)推薦國(guó)際學(xué)術(shù)會(huì)議和期刊目錄)收錄并在線發(fā)表。

該研究的唯一完成單位為安恒信息,是安恒信息中央研究院在信息安全和人工智能領(lǐng)域交叉創(chuàng)新和持續(xù)深耕的成果。ICICS是網(wǎng)絡(luò)信息安全領(lǐng)域的老牌學(xué)術(shù)會(huì)議,至今已經(jīng)舉辦24屆。該國(guó)際學(xué)術(shù)會(huì)議錄用比例較低,每年僅有30篇左右的論文可以錄用,2022年的錄用比例為22.7%。安恒信息的論文經(jīng)過(guò)5位專家審稿人2輪的同行審議(peer review),從全球164篇投稿論文中脫穎而出,被ICICS 2022成功錄用。

Webshell是一種可以讓攻擊者獲取主機(jī)權(quán)限的惡意腳本,攻擊者通過(guò)網(wǎng)站的漏洞上傳webshell后,可以持續(xù)的獲取主機(jī)的控制權(quán),因此webshell的檢測(cè)在網(wǎng)絡(luò)攻防環(huán)境中具有重要意義。Webshell種類繁多,語(yǔ)法靈活,傳統(tǒng)基于規(guī)則的方法、基于啟發(fā)式的方法和基于機(jī)器學(xué)習(xí)的方法在webshell檢測(cè)中都有一定的局限性,導(dǎo)致誤報(bào)率和漏檢率較高,而深度學(xué)習(xí)的方法可以充分挖掘文本的上下文信息,但仍然面臨處理長(zhǎng)文本時(shí)的低效和語(yǔ)義損失,以及在面對(duì)復(fù)雜語(yǔ)法時(shí)的一詞多義性問(wèn)題。

長(zhǎng)文本在webshell檢測(cè)領(lǐng)域是頻繁出現(xiàn)的,對(duì)已知webshell和正常樣本的代碼行數(shù)和token數(shù)統(tǒng)計(jì),一半以上的webshell代碼token個(gè)數(shù)超過(guò)3400,代碼行數(shù)超過(guò)49行,而一半以上的正常代碼token個(gè)數(shù)超過(guò)1000,代碼行數(shù)超過(guò)70. 所以需要合適的方法在保留核心語(yǔ)義的同時(shí)去除冗余信息。

文本長(zhǎng)度統(tǒng)計(jì)信息

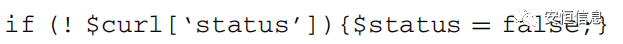

一詞多義在文本處理中是比較棘手的問(wèn)題,就像“蘋(píng)果”在不同的上下文中可以呈現(xiàn)水果的語(yǔ)義也可以呈現(xiàn)手機(jī)的語(yǔ)義。一詞多義在webshell檢測(cè)中表現(xiàn)為同一個(gè)名稱的token,有時(shí)呈現(xiàn)變量語(yǔ)義,有時(shí)呈現(xiàn)函數(shù)語(yǔ)義,有時(shí)呈現(xiàn)類成員語(yǔ)義等(如下圖中的‘status’分別呈現(xiàn)了成員語(yǔ)義和變量語(yǔ)義)。所以需要在不同的上下文中給token以不同的向量表示。

面對(duì)長(zhǎng)文本,論文采用了textrank模型來(lái)篩選重要語(yǔ)義信息,該算法可以通過(guò)相似度加權(quán)迭代的方式對(duì)代碼進(jìn)行重要性排序。

Textrank模塊架構(gòu)

面對(duì)一詞多義問(wèn)題,論文采用codebert方法學(xué)習(xí)token的上下文信息,在不同的語(yǔ)境下給token以不同的變量表示。

Codebert模塊架構(gòu)

結(jié)合textcnn結(jié)構(gòu)的分類head,模型的整體為一個(gè)two-stage的架構(gòu),loss在textcnn和codebert中進(jìn)行反向傳播,而textrank模型不參與誤差的反向傳播。

模型整體架構(gòu)

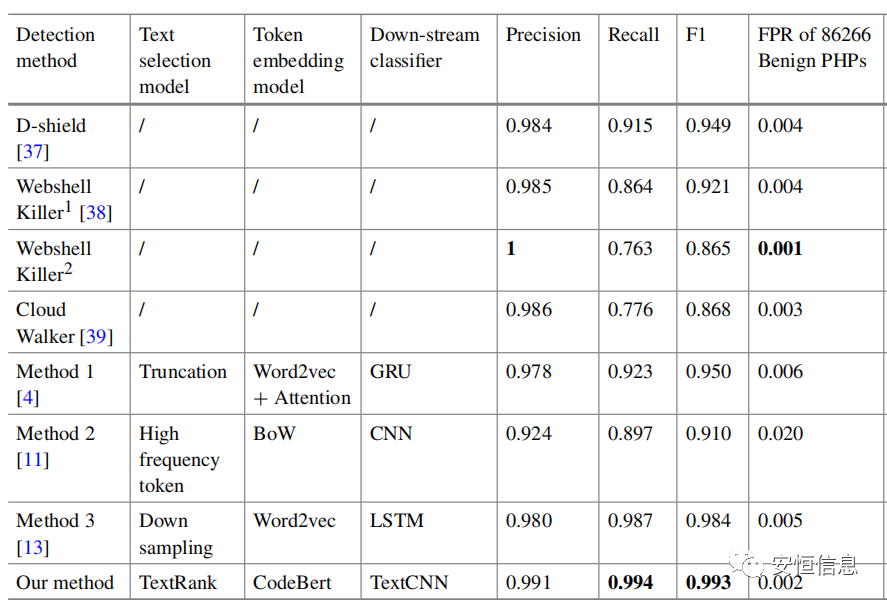

模型經(jīng)過(guò)數(shù)十epoch的訓(xùn)練,在數(shù)十萬(wàn)樣本的測(cè)試中,其綜合表現(xiàn)F1-score超過(guò)了3種webshell檢測(cè)工具和3種基于深度學(xué)習(xí)的webshell檢測(cè)模型。在達(dá)到較高檢出率的同時(shí),也保證了較低的誤報(bào)率。

部分實(shí)驗(yàn)結(jié)果

掃碼可下載原文

相關(guān)推薦

- 發(fā)布兩款產(chǎn)品!安恒信息亮相“第二屆海光安全技術(shù)高峰論壇”

- 數(shù)據(jù)安全與數(shù)據(jù)要素治理研討會(huì)在安恒信息舉行

- 官宣|賽事數(shù)字資產(chǎn)守門(mén)人·安恒EDR大運(yùn)會(huì)專版發(fā)布

- 安恒信息與電子科大網(wǎng)絡(luò)空間安全研究院達(dá)成戰(zhàn)略合作

- 因大運(yùn)結(jié)緣 以城市共生|成都大運(yùn)會(huì)官方贊助商安恒信息升級(jí)發(fā)布會(huì)暨西部網(wǎng)絡(luò)安全總部啟動(dòng)儀式成功舉辦

- 大運(yùn)會(huì)網(wǎng)絡(luò)安全衛(wèi)士|500名“全球網(wǎng)絡(luò)安全志愿者”獲聘任

- 案例入選!安恒信息出席2023中國(guó)數(shù)實(shí)融合50人論壇暨年度報(bào)告發(fā)布會(huì)

AI+安全

AI+安全 數(shù)據(jù)安全

數(shù)據(jù)安全 數(shù)據(jù)基礎(chǔ)設(shè)施

數(shù)據(jù)基礎(chǔ)設(shè)施 態(tài)勢(shì)感知

態(tài)勢(shì)感知 云安全

云安全 基礎(chǔ)安全

基礎(chǔ)安全 終端安全

終端安全 商用密碼

商用密碼 軟件供應(yīng)鏈安全

軟件供應(yīng)鏈安全 網(wǎng)絡(luò)空間靶場(chǎng)

網(wǎng)絡(luò)空間靶場(chǎng) 工業(yè)互聯(lián)網(wǎng)安全

工業(yè)互聯(lián)網(wǎng)安全 物聯(lián)網(wǎng)安全

物聯(lián)網(wǎng)安全

安全托管服務(wù)

安全托管服務(wù) 運(yùn)營(yíng)管理服務(wù)

運(yùn)營(yíng)管理服務(wù)